구글이 AI Overviews에도 Gemini 3를 적용하기 시작했습니다. AI Mode와 동일한 버전을 사용하게 됐는데요. 하지만 경량 모델입니다. 그리고 두 제품의 연결을 훨씬 부드럽게 가져가고 있습니다. AIO와 AI Mode의 경계를 희미하게 하되, AI Mode 사용을 자연스럽게 촉진하는 방향으로 재설계를 하는 중이라고 말씀드릴 수 있습니다.

사용자들은 구글 검색에서 이제 두 모델을 동시에 경험하게 될 확률이 높아졌습니다. 다른 한편으로는 GEO(Generative Engine Optimization) 관점에서 둘 모두에 최적화해야 하는 과제를 떠안게 됐다고 할 수 있죠. AI검색최적화는 더 복잡해졌고, 부담도 그만큼 늘어난 셈입니다.

자연스럽게 이런 궁긍증을 떠올리게 될 겁니다. 'AI Overviews와 AI Mode가 선호하는 출처는 다를까?' 얼핏 둘은 유사한 출처 인용 결과를 내놓을 수 있을 거라고 생각할 겁니다. 하지만 결과만 보면 명확한 특성 차이가 발견이 됩니다. 그 경향만 오늘은 전해드리도록 하겠습니다.

AI Overviews와 AI Mode는 출처 집중도가 다르다

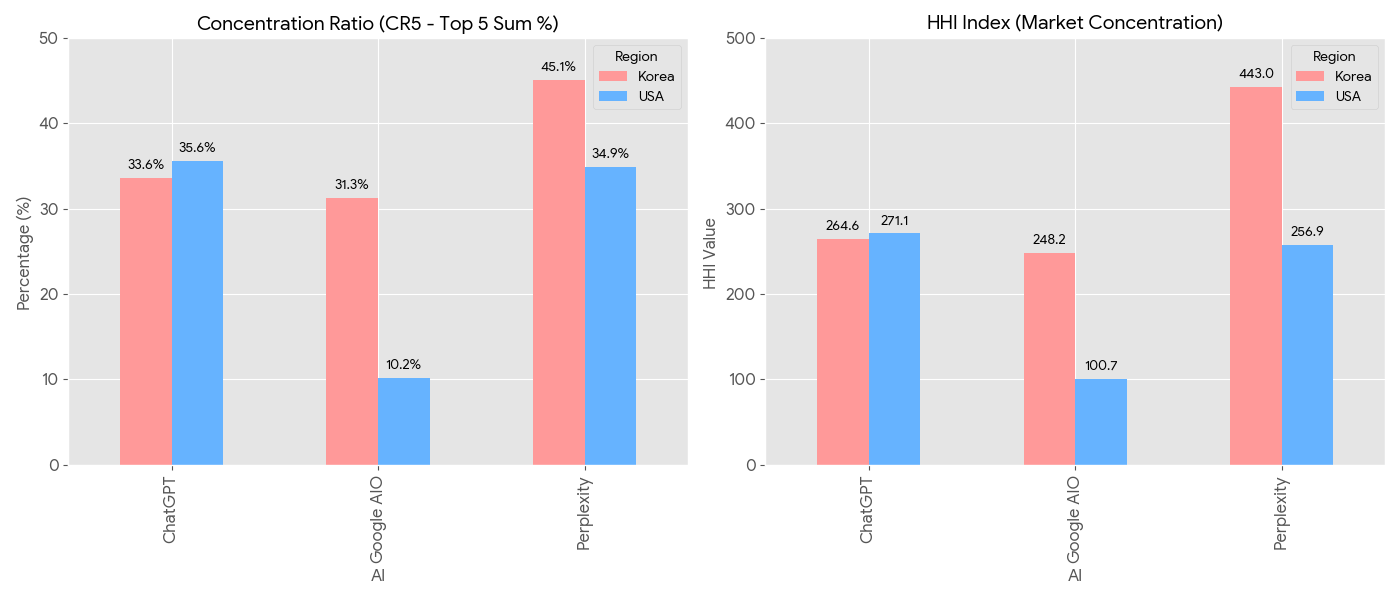

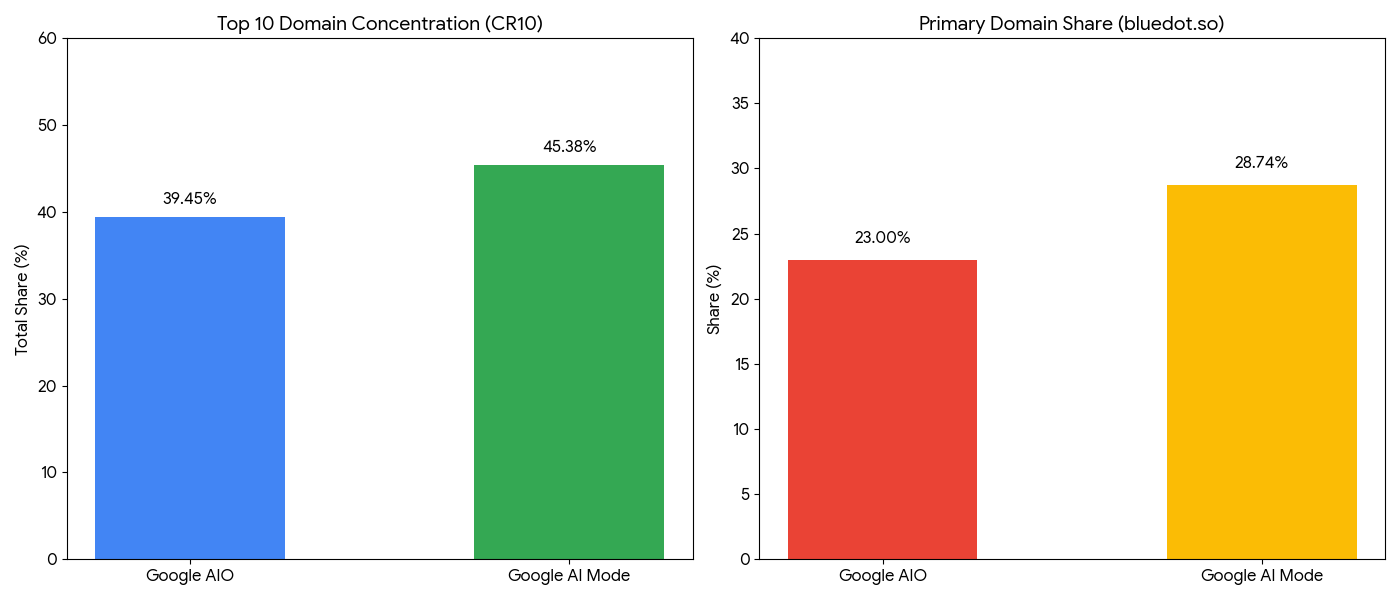

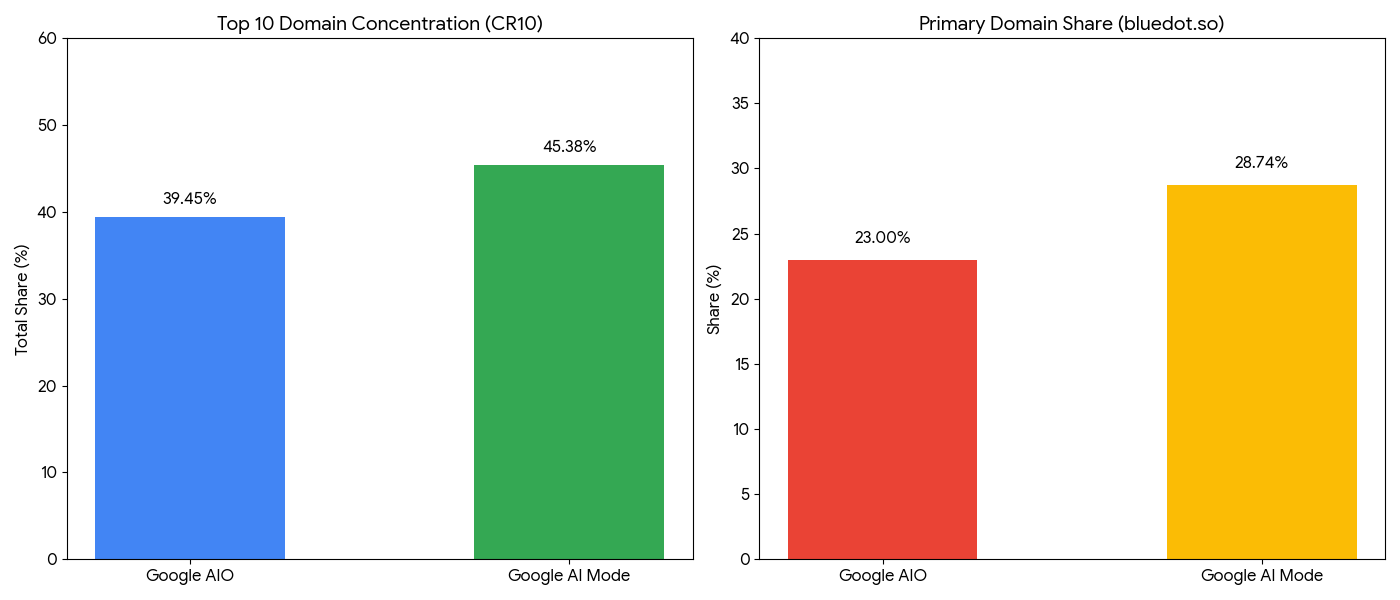

위 그래프는 '블루닷 인텔리전스'로 측정한 두 구글 검색 제품의 출처 집중도 차이입니다. 대상은 저희 블루닷이었습니다. 자체 연구를 위해 20여개의 프롬프트로 실험을 한 결과입니다. 보시다시피, 출처 인용 집중도가 Google AI Mode에서 더 높게 나타납니다. 양쪽 상위 10개 출처의 5일치 데이터를 분석한 결과입니다. 먼저 CR10 방법론으로 측정한 결과를 보면, Google AI Mode가 Google AI Overviews에 비해 약 6% 가량 집중도가 높습니다. 이는 오른쪽 그래프처럼 권위있는 출처의 쏠림 현상이 더 높게 나타나는 결과로 이어집니다.

쉽게 말해 Google AI Mode는 Google AI Overviews에 비해 출처 다양성은 다소 약한 편이지만 신뢰할 수 있는 출처를 더 자주 인용하는 특성을 보이고 있다는 얘기입니다. 앞선 글에서도 설명을 드렸다시피 출처 인용 집중도는 ChatGPT가 가장 높습니다. 상위 신뢰할 수 있는 출처 의존도가 높다는 의미죠. Google AI Mode는 Google AI Overviews와 ChatGPT의 사이에 위치한다고 말씀드릴 수 있습니다.

왜 Google AI Mode는 출처 인용 집중도가 더 높을까

이러한 차이의 원인을 밝히는 건 쉽지 않습니다. 그저 추정만 가능합니다. 일반적으로 Google AI Mode는 쿼리 팬 아웃(Query Fan Out)의 수준이 더 높습니다. 상위 추론모델의 일반적 특성이기도 합니다. 사용자의 질문이 들어오면 더 많은 의도로 쿼리를 쪼개 검색에 활용을 합니다. 세분화된 쿼리는 워낙 틈새 지향적이라 이를 만족시킬 수 있는 출처는 세상에 그리 많지 않습니다. '질적 허들'이 그만큼 높아지는 거죠.

만약 쪼개진 쿼리마다 반복적으로 추천되는 출처가 있다면 그 출처를 인용할 가능성이 높아집니다. 그리고 그 출처에 대한 의존도를 높이게 되는 거죠. 그래야만 더 신뢰할 수 있는 답변을 만들어낼 수가 있습니다. 결국 상위 모델의 쿼리 팬 아웃 구조와 필터링 아키텍처가 이러한 집중도를 만들어낸다고 볼 수 있습니다.

GEO를 위해 무엇을 준비해야 할까

모델의 성능은 향상되고 쿼리 팬 아웃의 심도는 더욱 깊어질 겁니다. 사용자들의 다양한 의도에 답변할 수 있는 포괄성을 지닌 콘텐츠를 보유해야 하고, 그만큼 하나의 콘텐츠에 담긴 정보 밀도도 높여야 합니다. 정보 밀도는 해당 토픽 엔티티의 청크 내 출현수와도 어느 정도 비례하죠. 팩트와 근거 기반의 고품질 콘텐츠가 갈수록 중요해질 수밖에 없다는 신호입니다.

AI Agent 시대는 데이터 떠먹임(ingestion)의 최적화 시대라고 얘기할 수 있습니다. 즉, 어느 쪽이 더 신뢰할 수 있는 데이터를 에이전트에게 더 많이 제공하느냐가 핵심인 세상입니다. 구조화된 형태로 가장 품질 높은 데이터오 콘텐츠를 만들어낼 수 있어야 GEO 생태계에서 살아남을 수 있습니다. 늘 염두에 두시길 바라며...

![[블루닷 인텔리전스 업데이트] 프롬프트 추천, AI Mode 추가](https://cdn.media.bluedot.so/bluedot.mediasphere/2026/01/xsff2p_202601280503.08.png)